Vertrauen in KI-Systeme

Menschen und Unternehmen müssen auf die Sicherheit von KI-Systemen vertrauen können. Regeln für die Entwicklung und den Einsatz von KI schützen sie vor möglichen Gefahren. Zugleich schaffen einheitliche Regeln faire Wettbewerbsbedingungen für die Wirtschaft in Europa. Damit Regelungen nicht die Innovationskraft beschneiden, gilt es die richtige Balance zwischen einer vertrauensstiftenden Gestaltung der Technologie und der Innovationsförderung für den Wirtschaftsstandort zu finden. Nur so lässt sich das Potenzial der Künstlichen Intelligenz für Wirtschaft und Gesellschaft ausschöpfen.

Risiko eines Systems bewerten: die Kritikalität entscheidet

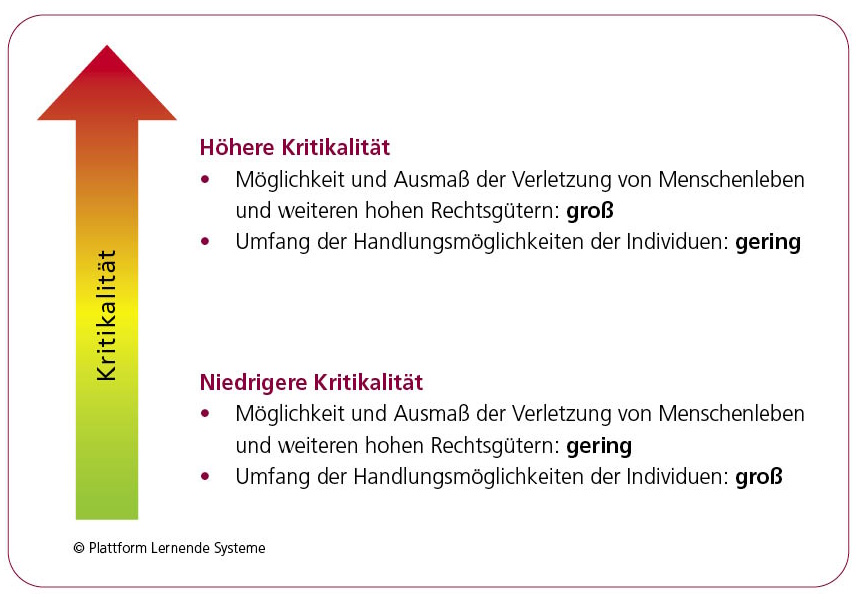

Wie lässt sich beurteilen, ob ein KI-System vertrauenswürdig oder riskant ist? Viele Expertinnen und Experten, auch innerhalb der Plattform Lernende Systeme, schlagen eine sogenannten Kritikalitätsbewertung vor. Anhand dieser lassen sich Risikofaktoren prüfen und Regeln für eine vertrauenswürdige KI ableiten. Die Kritikalität eines KI-Systemen wird entlang zweier Dimensionen bewertet.

Gefahrenlage:

Wie hoch ist die Wahrscheinlichkeit, dass durch Empfehlungen oder Entscheidungen der KI-Anwendung Menschenleben, Rechte von Personen, Unternehmen, Objekte oder die Umwelt gefährdet werden? Wie groß ist das Ausmaß dieser möglichen Gefährdung?

Handlungsspielraum:

Welche Möglichkeiten bleiben den Nutzerinnen und Nutzern, um auf das KI-System einzuwirken, KI-basierte Entscheidungen zu korrigieren oder in letzter Konsequenz die Funktionsweise des Systems zu unterbrechen?

Wichtig dabei ist, ein KI-System nicht allgemein, sondern in seinem konkreten Einsatzkontext zu betrachten. Das gleiche System kann in einem Zusammenhang unproblematisch und in einem anderen höchst kritisch sein. KI für die Detektion von Hate Speech kann zum Beispiel zunächst als vergleichsweise unbedenklich gelten. Wenn die gleiche Anwendung aber von einem totalitären Staat genutzt wird, um kritische Stellungnahmen ausfindig zu machen, dann fällt die Bewertung gegenteilig aus.

Am Risiko der Anwendung und den Handlungsmöglichkeiten des Menschen sollten sich die Regeln für KI orientieren. Dabei gilt folgende Faustregel: Je höher Risiko und Ausmaß der Verletzung und je geringer der menschliche Eingriffsspielraum, desto stärker sollte ein KI-System reguliert werden – und vice versa.

Ein Großteil der aktuell verwendeten KI-Systeme hat ein niedriges Kritikalitätslevel. Sie bedürfen keiner strikten Regulierung. Für risikobehafteter KI-Systeme sollten klare Regeln gelten, die ihren Einsatz vertrauenswürdig machen.

Publikationen zum Thema