So funktioniert generative KI

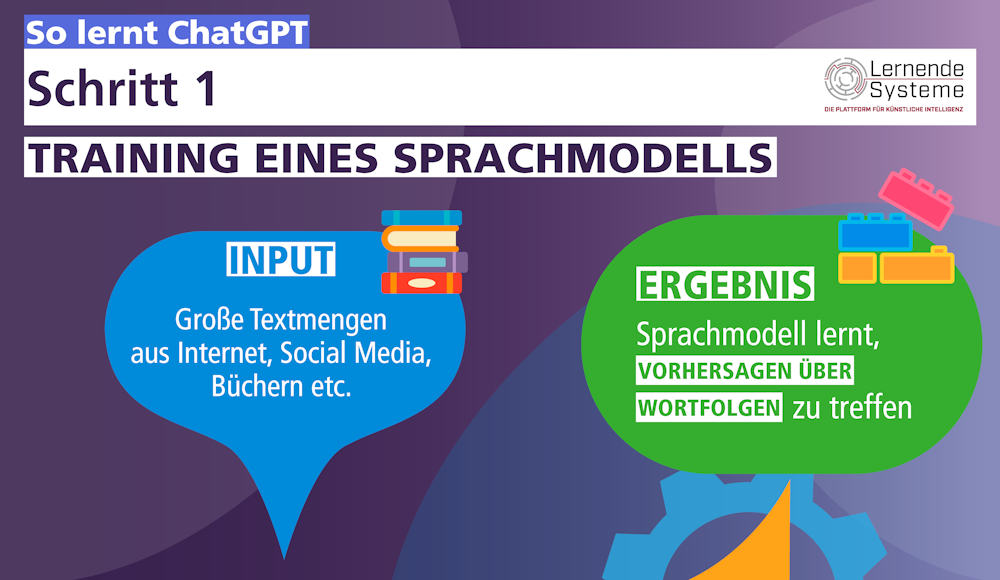

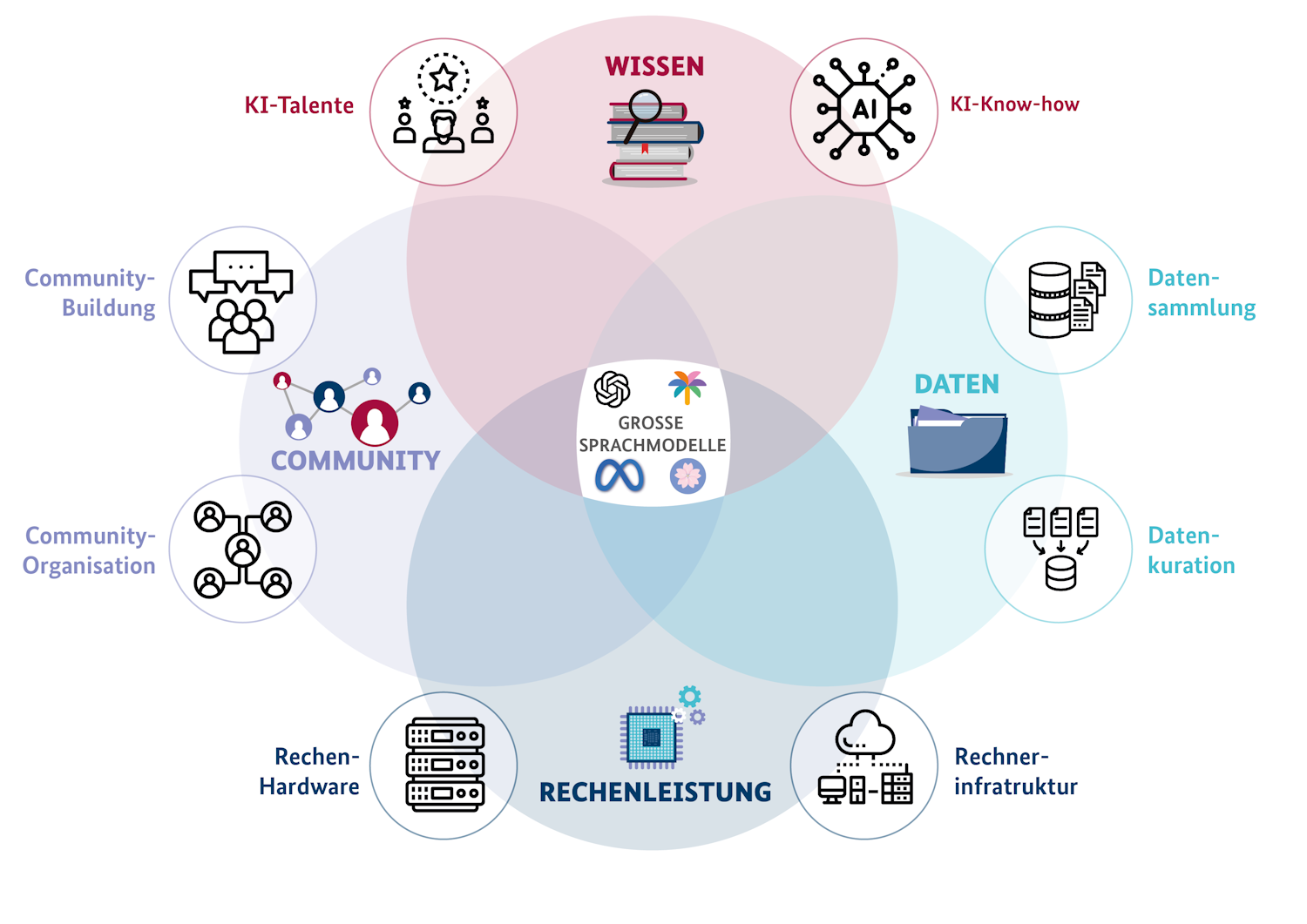

Generative KI erstellt aus vorhandenen Informationen und Daten – hauptsächlich aus Internet und Social Media – neue Inhalte. Die Grundlage dieser Technologie sind vorab trainierte Modelle, die als Basismodelle fungieren. Sie benötigen riesige Datenmengen, große Rechenleistung sowie lernende Algorithmen.

Multitalent mit Transformer-Architektur

Generative KI-Modelle basieren auf einer Netzwerkarchitektur, die der Struktur des menschlichen Gehirns ähnelt, der sogenannten Transformer-Architektur. Diese Netzwerkarchitektur besteht aus künstlichen Neuronen, die miteinander verbunden sind und Informationen verarbeiten. Dafür kommen Deep-Learning-Techniken zum Einsatz, um komplexe Muster oder Wahrscheinlichkeiten zu erkennen und neue Ergebnisse bei der Verarbeitung von Text, Bildern etc. zu generieren.

Die Funktionsweise generativer KI-Modelle basiert auf der Idee, dass Wörter, die in ähnlichen Kontexten vorkommen, ähnliche Bedeutungen haben. Hierfür kommen Transformer-Architekturen zum Einsatz. Diese bilden die Grundlage für die mathematische Abbildung der Beziehung zwischen einem Wort und seinem Kontext in Form eines Vektors. Zuerst werden Wörter in Vektoren (sog. Embeddings) umgewandelt, die ihre Bedeutung darstellen. Durch die Anordnung der Vektoren lassen sich Ähnlichkeiten zwischen Wörtern messen: Ähnliche Wörter haben ähnliche Vektordarstellungen.

Anhand der Vektordarstellungen werden im Weiteren spezifische Aufgaben zur Generierung neuer Inhalte von den einzelnen Schichten der Transformer-Architektur ausgeführt. Die unteren Schichten erkennen Wortbestandteile und setzen sie zu ganzen Wörtern zusammen. Die höheren Schichten erkennen komplexere Beziehungen zwischen Wörtern und Sätzen.

Beispiel: Ich gehe heute schwimmen, da das Wetter…

Mit hoher Wahrscheinlichkeit würden die meisten Menschen aus ihrer Erfahrungswelt heraus eher “schön ist” als “schlecht ist” ergänzen. Bei generativen KI-Modellen ermöglicht es die Transformer-Architektur, verschiedene Bedeutungsaspekte von Wörtern in unterschiedlichen Kontexten einzuteilen, zu klassifizieren und somit zu lernen.

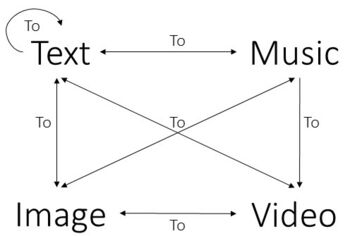

Generative KI-Systeme können verschiedene Arten von Daten gleichzeitig verarbeiten, wodurch sie eine Vielzahl von Aufgaben ausführen können:

Das erklärt auch die Abkürzung „GPT“: Diese steht für „generative pre-trained transformer“ und bedeutet, dass diese KI-Modelle darauf trainiert wurden, Inhalte aller Art automatisch zu erzeugen und hierfür auf bereits gesammelte Erfahrungen zurückgreifen.

Beispiel ChatGPT

- Das Sprachmodell kann ...

- natürlich klingende Konversationen führenTexte aller Art erstellen (Aufsätze, Gedichte, Zusammenfassungen, Kochrezepte etc.)gewünschten Stil imitieren (sachlich, poetisch etc.)Programmcode generierenTexte übersetzen u. v. m.

- Basiert auf …

- Textdaten aus dem Internet (Wikipedia etc.)Büchern

- Funktioniert …

- auf Basis von Wahrscheinlichkeitenmittels KI-Algorithmen und mit aufwändigem Training unter Nutzung menschlicher Bewertungen von generierten Inhalten

- Es hat aber auch Grenzen:

- Liefert immer eine Antwort (auch wenn die Datenbasis nicht ausreichend Informationen zur Anfrage enthält)Erfindet bisweilen Inhalte oder Quellen („halluziniert“)Und weitere …

Mehr zu Funktionsweise und Chancen von generativer KI:

Besonderheiten von generativer KI

Generative KI-Modelle werden aufgrund ihrer großen Potenziale ständig weiterentwickelt und verbessert. Verglichen mit bisherigen KI-Systemen zeichnet sie sich durch folgende Eigenschaften aus:

- Skalierbarkeit: Die immense (teils in Milliardenhöhe), ermöglicht es generativer KI komplexe Muster in großen Mengen unstrukturierter Daten zu erkennen und eine breite Palette von Aufgaben zu bewältigen.

- Anpassungsfähigkeit: Ihre hohe Anpassungsfähigkeit zeichnet generative KI als Foundation-Model (Basis-Modell) aus. Vereinfacht gesagt handelt es sich dabei um große, mit Unmengen an Daten trainierte KI-Modelle, die für konkrete Anwendungen sowie Aufgaben weiter spezifiziert und modifiziert werden können. Zum Einsatz kommen folgende Adaptionsmethoden:

- Prompting Engineering: Prompting ist eine Eingabeaufforderung an das Sprachmodell: Je nachdem, wie allgemein oder wie spezifisch ein Prompt gestellt wird, fällt die Antwort der KI unterschiedlich aus.

- Finetuning: Unter Feinabstimmung versteht man das erneute Trainieren eines vortrainierten Sprachmodells mit eigenen Daten.

- Few-Shot Learning: Diese Methode erlaubt die Anpassung eines Modells an neue Problemstellungen durch die Nutzung nur weniger Beispiele.

- Vielfältige Einsatzmöglichkeiten: Generative KI-Modelle sind in unterschiedlichen Anwendungen und Branchen einsetzbar, etwa für Aufgaben wie Übersetzung, Textgenerierung, Frage-Antwort-Systeme und Textklassifikation.

Übersicht: Bedeutende generative KI-Modelle

Generative KI ist äußerst vielseitig, die einzelnen Modelle können in verschiedenen Anwendungen eingesetzt werden. Einige Beispiele:

- Name des Modells

- Entwickler

- Charakteristika

- ChatGPT (Generative Pre-trained Transformer)

- OpenAI

- Im November 2021 als erstes Sprachmodell für die kostenlose Nutzung veröffentlichtBasiert in der Pro-Version auf GPT-4, einem multimodalen Modell

- BERT (Bidirectional Encoder Representations from Transformers)

- Bidirektionales Transformer-ModellKann Wörter durch ihren gesamten Kontext vorhersagenBasis für eine Familie von KI-Modellen, die sich von GPT abgrenztNützlich für viele KlassifikationsaufgabenWird z. B. in der Google-Suche eingesetzt

- BLOOM (Biologically Localized and Online One-shot Multi-Task Learning)

- Hugging-Face

- Open-Source-KI-SprachmodellAufbau durch internationale Community von Freiwilligen

- LLaMA & LLaMA2 (Large Language Model Meta AI)

- Meta/Microsoft

- Open-Source-KI-SprachmodellHohe Leistungsfähigkeit trotz kleiner Parameteranzahl

- Luminious

- Aleph Alpha

- Setzt auf Erklärbarkeit der ModelleBei verschiedenen Fähigkeiten auf Augenhöhe mit GPT-3Bislang einziges Sprachmodell aus Deutschland

- Claude & Claude2

- Anthropic

- Fokussiert auf Sicherheit, um schädliche, unethische oder illegale Ausgaben zu vermeidenGroße Eingabekapazität (bis zu 100.000 Token-Eingaben)Fortgeschrittene Mathematik-, Denk- und Programmierfähigkeiten

Was weiß generative KI wirklich?

Ein Gedankenexperiment:

Kann Künstliche Intelligenz die Bedeutung von Begriffen erfassen und mit der realen Welt in einen Zusammenhang bringen? Der Oktopus-Test veranschaulicht, dass KI keine wirkliche Vorstellung davon hat, was beispielsweise ein Bär oder ein Stock ist. Der Grund: Hierfür fehlt ihr der Bezug oder die Verbindung zu Objekten in der realen Welt (Grounding).

Was muss noch verbessert werden?

Generative KI-Modelle gelten als Meilenstein der KI-Entwicklung. Gleichwohl steht die Forschung noch vor manchen Herausforderungen bei der Entwicklung von Modellen, die einen verantwortungsvollen Einsatz dieser Technologie gewährleisten.

- Qualität der Trainingsdaten erhöhen: Um mit qualitativ hochwertigen Datensätzen zu trainieren, müssen die Methoden zur Erstellung von Trainingsdaten effizienter gestaltet werden, sodass möglichst wenig menschliche Annotationsarbeit nötig wird.

- Transparenz herstellen: Generative KI-Modelle sind häufig noch intransparent und ihre Ergebnisse nicht immer nachvollziehbar. Hier sind erklärbare Ansätze erforderlich.

- Verzerrung und Diskriminierung vermeiden: In Abhängigkeit von den zugrunde liegenden Trainingsdaten können die Modelle falsche oder diskriminierende Inhalte produzieren oder reproduzieren. Entscheidend sind hier die für das Training der Modelle genutzten Daten.

- Faktenwissen integrieren: Generative KI-Modelle haben kein Faktenwissen. Die Vermittlung von Fakten durch Wissensmodellierung über Wissensgraphen ist wesentlich, um das logische Schlussfolgern generativer KI-Modellen zu verbessern.

- Nachhaltigkeit sicherstellen: Der Energieverbrauch bei Training und Einsatz generativer KI-Systeme ist sehr hoch. Hier sind neue Methoden zur Ressourcen- wie Energieeffizienz gefragt.

- Gesellschaftliche Auswirkungen bedenken: Der rasante technologische Fortschritt eröffnet vielfältige Einsatzmöglichkeiten von generativer KI. Damit dies verantwortungsvoll geschieht, müssen potenzielle gesellschaftliche Auswirkungen berücksichtigt und ethische Richtlinien definiert werden.

Große Sprachmodelle sind nicht perfekt

„Aus der Perspektive der KI-Forschung stellen große Sprachmodelle einen bedeutenden technologischen Durchbruch dar. Sie erschließen die Intelligenz der Sprache. Sie ermöglichen Lösungen, die vorher jenseits der technologischen Möglichkeiten waren, und heute bereits als selbstverständlich erscheinen. Allerdings sind die Modelle nicht perfekt. Die wissenschaftliche Gemeinschaft debattiert leidenschaftlich darüber, inwieweit große Sprachmodelle eine authentische Intelligenz besitzen.“

Prof. Dr. Volker Tresp, Professor für maschinelles Lernen an der Ludwig-Maximilians-Universität München